免责申明

本公众号的技术文章仅供参考,此文所提供的信息只为网络安全人员对自己所负责的网站、服务器等(包括但不限于)进行检测或维护参考,未经授权请勿利用文章中的技术资料对任何计算机系统进行入侵操作。利用此文所提供的信息而造成的直接或间接后果和损失,均由使用者本人负责。本文所提供的工具仅用于学习

,禁止用于其他!!!

部署架构概述

接下来,我们将一步步完成通过 Ollama、DeepSeek R1 与 AnythingLLM 搭建高效本地知识库系统的过程,系统中的每个组件都至关重要。

1. DeepSeek R1:作为语言理解领域的 “新秀”,DeepSeek 专注于前沿人工智能技术研发,其开源的 R1版本在逻辑推理和处理复杂自然语言任务方面表现出色。凭借优秀的语言能力,它成为构建知识库的核心引擎。2. Ollama:这是一款专为本地运行大模型设计的工具,提供简单直观的命令行界面,拉取、运行和管理不同语言模型都变得轻松便捷,无需繁琐配置或高昂的云计算成本。用户能快速切换模型,满足多样化应用场景的需求。3. AnythingLLM:主要侧重于知识管理和问答交互,通过桌面客户端把各类文档、网页和数据库等非结构化数据整合为可查询的知识图谱。它能准确理解用户提问,并从知识库中精准检索出答案,实现高质量的智能问答。

本系统整体架构由 Ollama、DeepSeek R1 和 AnythingLLM 三部分构成,各模块协同工作,形成完整的本地知识库:

1. 预备阶段:确认系统环境符合要求,安装 Ollama、DeepSeek R1 模型以及 AnythingLLM 客户端。2. 数据导入:整理待收录的文本资料,借助 AnythingLLM 构建知识图谱。3. 模型连接:利用 Ollama 启动 DeepSeek R1模型,并将其与 AnythingLLM 对接,实现语言处理与知识管理的无缝衔接。** 4. 测试优化**:通过多轮问答测试,对系统参数和知识库内容进行微调,不断提升问答准确率和响应速度。

当前环境

操作系统参数如下:

操作系统:支持 MacOS、Linux 与 Windows 。硬件配置建议:

| 模型规模 | CPU 最低要求 | 内存建议 | 硬盘空间 | 显卡推荐 | 适用场景 |

|---|---|---|---|---|---|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

提示:GPU 并非必需,但使用 GPU 能获得更佳性能,详细信息可参考 Ollama GPU 支持列表。

安装Ollama

Ollama 是一个开源的大型语言模型(LLM)平台,专注于让用户在本地轻松运行、管理和与大型语言模型交互。

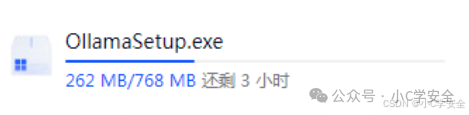

官网:`https://ollama.com/download` 选择windows下载,可以根据自己的操作系统下载对应的ollama一定要选择windows10或者更高版本,要不然无法安装等待下载

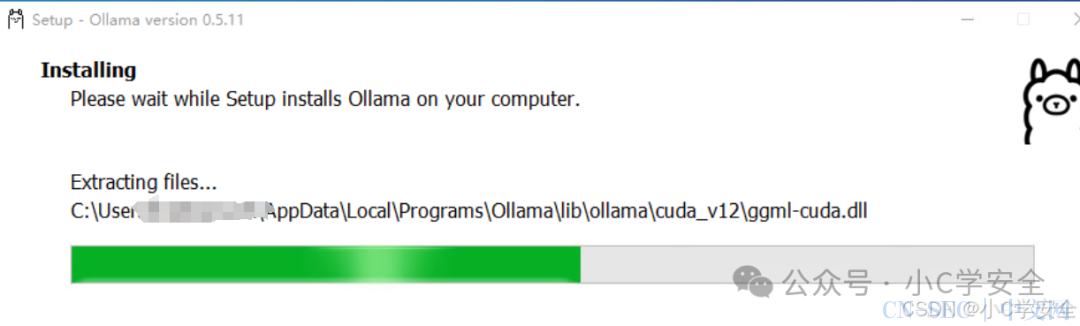

选择windows下载,可以根据自己的操作系统下载对应的ollama一定要选择windows10或者更高版本,要不然无法安装等待下载 下载完成后直接安装。点击OllamaSetup.exe文件。等待安装

下载完成后直接安装。点击OllamaSetup.exe文件。等待安装 在命令行终端执行

在命令行终端执行ollama -v命令获取ollama的版本信息当前版本为0.5.11,证明已安装成功

http://127.0.0.1:11434![【技术前沿】五分钟打造你的专属 AI 助手:Ollama + DeepSeek R1 + AnythingLLM 完整整合指南]()

部署DeepSeek-R1模型

可以根据自己设备性能选择对应的模型版本本次选择7b模型

ollama run deepseek-r1:7b![【技术前沿】五分钟打造你的专属 AI 助手:Ollama + DeepSeek R1 + AnythingLLM 完整整合指南]()

注意:下载过程受网络速度影响,请耐心等待。如果显示success,就代表已经部署成功。

部署AnythingLLM

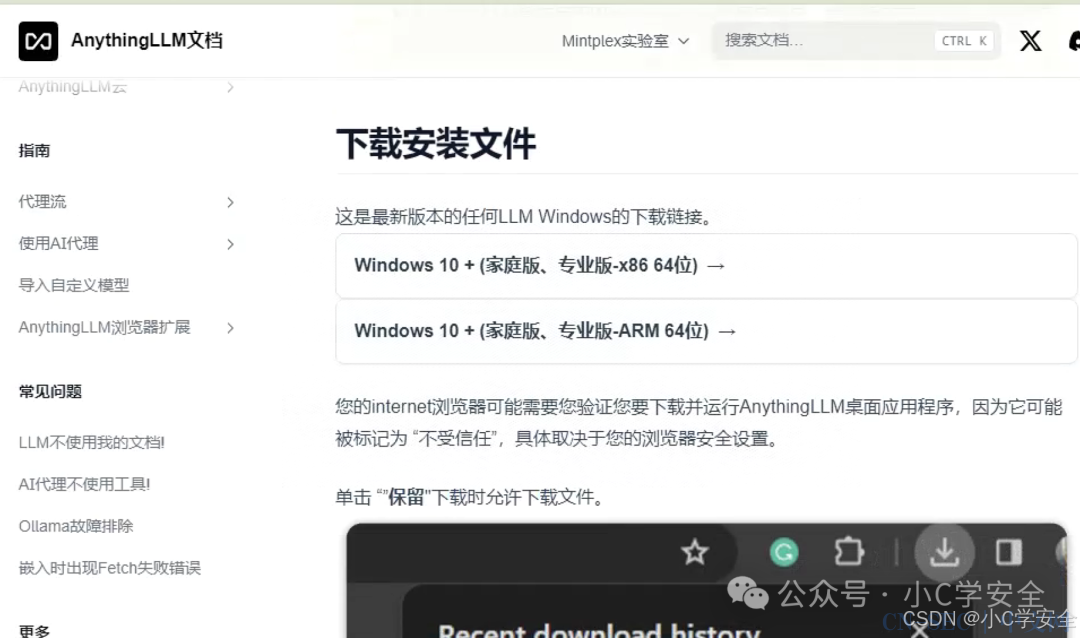

AnythingLLM 是 mintplexlabs 推出的全栈 AI 应用程序,可作为桌面应用或 Docker 应用。旨在帮助用户将各种文档、资源等转换为背景信息,供大型语言模型在聊天时使用。

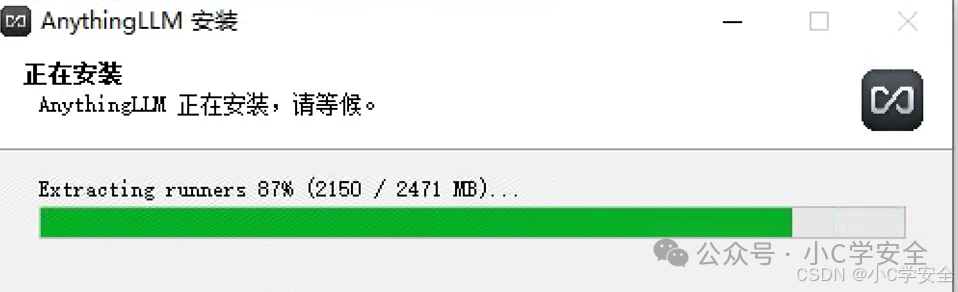

下载链接:https://docs.anythingllm.com/installation-desktop/windows#install-using-the-installation-file 下载完成后运行安装文件可以根据文档内容的步骤进行安装(一键式下一步安装)安装期间,会自动下载安装一些组件

下载完成后运行安装文件可以根据文档内容的步骤进行安装(一键式下一步安装)安装期间,会自动下载安装一些组件 安装成功

安装成功

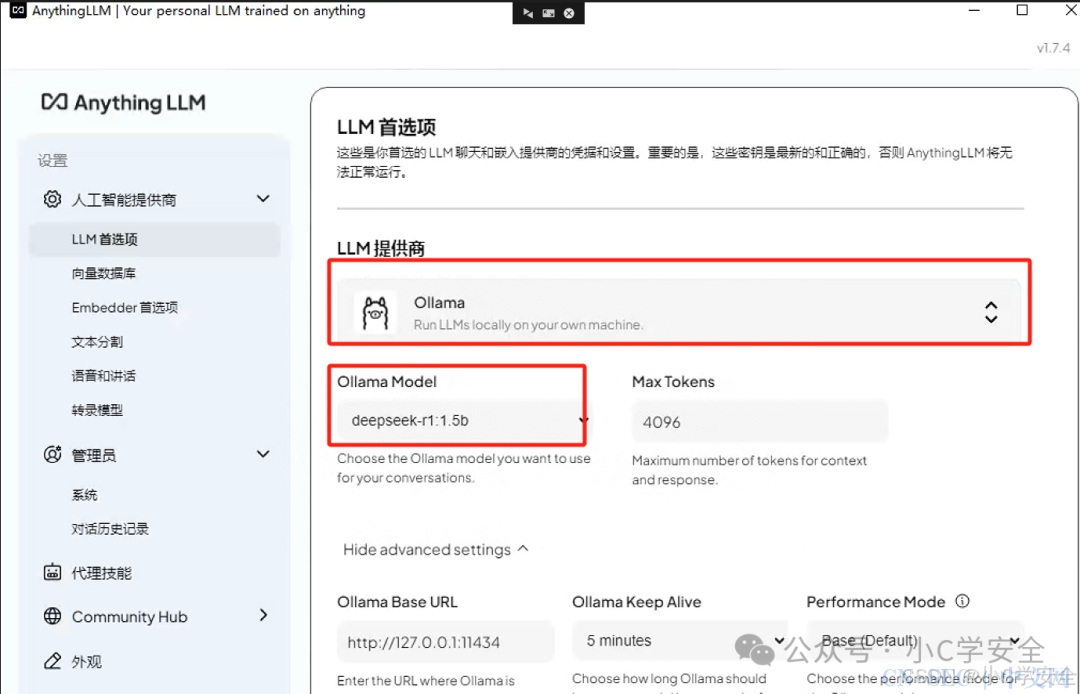

配置AnythingLLM+Ollama

配置LLM首选项,这里只需要选择LLM提供商和对应的模型 向量数据库可以不配置。(ps:如果没有选择安装目录,默认在c盘)

向量数据库可以不配置。(ps:如果没有选择安装目录,默认在c盘)

ollama pull nomic-embed-text“Max Embedding Chunk Length”定义了在将文本分割成多个块(Chunk)时,每个块的最大长度,数字越小代表文本文件会被切分的更加细致。最好改为128~512之间

知识投喂+训练创建知识库

在构建知识库前,需准备好相关文档(如 txt、pdf、doc 格式)。将感兴趣的技术文档、论文或报告整理好后,通过 AnythingLLM 创建新的工作区,并上传文件。上传后点击 “Save and Embed”,系统会自动解析并嵌入文档内容,供后续问答使用。

点击图标上传 这里上传高项的第五章知识点。

这里上传高项的第五章知识点。

-

选择文档点击 “Move to Workspace”

-

点击 “Save and Embed”

-

出现 “Workspace updated successfully.”

上传成功后,进行一次对比。

投喂前

投喂后

从结果来看,进行投喂训练后,回答数据更加的精准。

在线数据源添加

可以通过数据连接器直接获取解析网络内容,例如GitHub、Youtube、或者抓取网站内容,等待抓取网站内容结束后,添加到工作区,可以直接引用抓取的数据来生成回答内容。

结论

通过整合 Ollama、DeepSeek R1 和 AnythingLLM,你可以在本地构建一个高效且安全的知识库,轻松实现智能问答、文档处理等多种功能,满足个性化和专业化的需求。

关注公众号

扫码关注

小C学安全

获取更多精彩资讯

原文始发于微信公众号(小C学安全):【技术前沿】五分钟打造你的专属 AI 助手:Ollama + DeepSeek R1 + AnythingLLM 完整整合指南

- 左青龙

- 微信扫一扫

-

- 右白虎

- 微信扫一扫

-

评论