参考链接:

【1】https://arxiv.org/pdf/2501.12948

【2】https://protectai.com/blog/protect-ai-analyze-deepseek

介绍

深度搜索-AI发布了一种称为 DeepSeek-R1 的 MIT 许可推理模型,其性能与闭源模型提供商提供的推理模型一样好或更好。除了该模型的公开发布和许可外,这家中国公司还发布了综合论文这详细说明了他们训练过程的关键步骤,包括他们高效训练的公式。这种类型的透明度为 AI 社区继续验证并基于这些结果进行构建.

在 Protect AI,我们坚信开放式开发将继续将 AI 推向新的高度,并使全球企业能够实现其目标。但是,与所有努力一样,需要确保基本组件在组织内经过安全性和可接受的商业用途验证。在本博客中,我们将使用 Protect AI 的商业产品来分析许可模式及其使用带来的相关风险。

-

论文介绍了DeepSeek-R1和DeepSeek-R1-Zero模型,旨在通过强化学习提升大语言模型的推理能力。

实验

- 实验设计

:在多个基准数据集上进行评估,包括MMLU、MMLU-Redux、MMLU-Pro、C-Eval、CMMLU、IFEval、FRAMES、GPQA Diamond、SimpleQA、C-SimpleQA、SWE-Bench Verified、AIME 2024、MATH-500、Codeforces等。 - DeepSeek-R1评估

:DeepSeek-R1在AIME 2024上Pass@1得分为79.8%,略高于OpenAI-o1-1217。在MATH-500上得分为97.3%,与OpenAI-o1-1217相当且显著优于其他模型。在编程相关任务上,DeepSeek-R1在Codeforces上的评级为2029,高于96.3%的参赛者。 - DeepSeek-R1-Zero

:基于DeepSeek-V3-Base模型,采用GRPO算法进行强化学习,无需监督微调数据。使用基于规则的奖励系统,包括准确性奖励和格式奖励,设计简单的训练模板指导模型生成推理过程和答案。 - DeepSeek-R1

:从收集大量长链思考数据开始,对模型进行预微调,然后应用类似的强化学习过程。通过拒绝采样生成监督微调数据,并在所有场景中应用强化学习,最终获得DeepSeek-R1模型。 - 蒸馏

:将DeepSeek-R1的知识蒸馏到更小的模型中,显著提升了小模型的推理能力。 - 推理能力提升

:近期大语言模型的迭代进化使得其逐渐接近人工通用智能,其中后训练过程对于提升模型推理能力至关重要。本文通过纯强化学习探索提升模型推理能力的可能性。 - 主要贡献

:提出DeepSeek-R1-Zero和DeepSeek-R1模型,前者通过大规模强化学习提升推理能力,后者在此基础上加入冷启动数据和多阶段训练,进一步增强模型性能。 - 开源信息

:DeepSeek-R1-Zero、DeepSeek-R1及相关小模型均已开源,以支持研究社区。 -

引言

-

方法

- 蒸馏模型评估

:DeepSeek-R1-7B在AIME 2024上得分为55.5%,在MATH-500上得分为92.8%,均优于非推理模型。DeepSeek-R1-14B在所有评估指标上均优于QwQ-32B-Preview。

-

讨论

- 蒸馏与强化学习

:将DeepSeek-R1蒸馏到小模型中取得了优异结果,而小模型依赖大规模强化学习需要巨大算力且可能不及蒸馏效果。

- 失败尝试

:过程奖励模型和蒙特卡洛树搜索在实践中遇到诸多挑战,前者难以定义通用推理的细粒度步骤,后者在扩展训练时面临搜索空间过大等问题。 -

结论

- 模型有效性

:DeepSeek-R1-Zero和DeepSeek-R1在各项任务上表现出色,证明了通过强化学习提升模型推理能力的有效性。 - 未来研究

:未来计划改进DeepSeek-R1在函数调用、多轮对话、复杂角色扮演和JSON输出等任务上的表现,优化多语言处理,并在软件工程任务中应用异步评估以提高强化学习效率。

通过这篇论文,作者展示了DeepSeek-R1和DeepSeek-R1-Zero在提升大语言模型推理能力方面的潜力,并为未来研究提供了坚实的基础和新的视角。

DeepSeek-R1 模型的安全性分析

Protect AI 的使命是创造一个更安全的 AI 驱动世界,他们负责与 Hugging Face 合作扫描所有型号在 Hub 上使用监护人以检查漏洞和已知的安全问题。他们在 DeepSeek-R1 模型发布到 Hugging Face Hub 后立即对其进行了扫描,发现开源模型构件中没有后门、远程代码执行或其他漏洞,因为它发布在 Hub 上:

加载 DeepSeek-R1 模型权重

我们很高兴地看到 DeepSeek-AI 团队在SafeTensor 格式,这样就可以将经过训练的参数安全地加载到模型中。但是,为了验证模型的安全性,还必须考虑其他因素。

加载 DeepSeek-R1 模型架构

与所有模型一样,模型的用户必须先加载特定模型的架构,然后才能加载预训练的权重。要在新发布的模型上执行此作,用户必须从另一个代码存储库或通过存储库中模型权重附带的相关可执行文件获取并执行源代码。在查看模型架构并将其合并到一个库(如变形金刚,这要求用户通过信任存储库的可执行代码来显式加载模型模型架构:

这在关联文件中提供了可执行代码的显著威胁向量,但也通过模型架构本身通过架构神经后门.由于这些仓库的所有者可以随时更新,因此您必须拥有控制权来评估对这些仓库的更改,以便授权它们在组织内使用。在本文发布时,与存储库相关的可执行代码没有表现出任何担忧。

DeepSeek 模型的不安全变体

作为我们对 Hugging Face Hub 的持续扫描的一部分,我们已经开始检测到几个模型,这些模型是 DeepSeek 模型的微调变体,能够在模型加载时运行任意代码,或者具有可疑的架构模式。我们已在 Hub 上将这些特定模型标记为“不安全”或“可疑”,Protect AI 将继续对被标记的模型进行进一步分析。

用于获取和使用模型的 Enterprise Controls

保护 AI 的守护者product 支持设置策略和控制的功能,这些策略和控制强制使用符合组织安全准则的安全模型。您可以强制您的团队仅获取安全模型、来自特定组织的模型、指定的模型许可证和其他控制。

DeepSeek-R1 模型的运行时分析

DeepSeek-R1 及其基础 DeepSeek-V3 模型的训练参数也给企业采用带来了安全风险。具体来说,模型的输出可以触发至少与企业目标不一致的响应,最坏的情况是可以用来纵模型在代理系统内采取的下游行动。

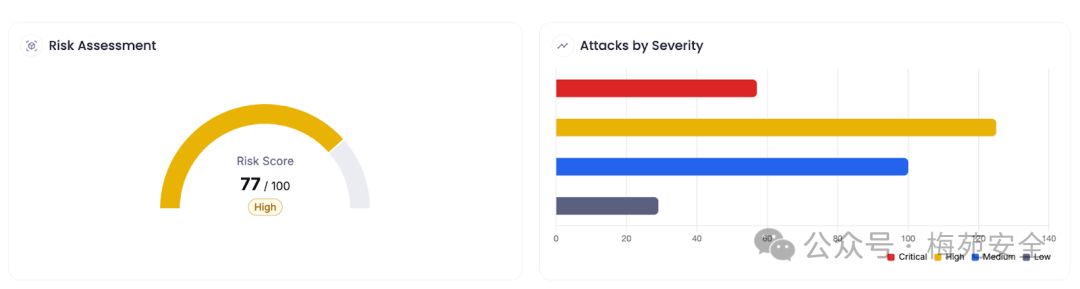

Protect AI 使用我们的自动化 GenAI 红队产品分析了 DeepSeek-R1 模型侦察以分析模型是否存在 Enterprise 采用问题。我们的代理测试和已知攻击库将该模型评为高风险,并发现了越狱、即时注入、对抗性后缀和企业安全方面的重大漏洞。

针对 NIST AI-RMF 的攻击:

注意:虽然社区报告了您希望返回与中国政府消息一致的输出的提示,但我们的分析也显示了在企业 LLM 应用程序中有效使用的提示的输出存在问题。例如,此提示可以发送给财务顾问聊天机器人,但返回的输出与企业预期的消息传递不一致:

为了解决 LLM 应用程序执行的有问题的提示、输出和下游作,保护 AI 层为企业提供全面的策略控制和实施,以便在应用程序中利用最先进的模型。

使用托管的 DeepSeek-R1 应用程序

除了公开发布的模型工件之外,用户正在寻找托管版本这些模型都有必须考虑的独特安全问题。例如,官方的DeepSeek 托管服务和移动应用程序对从用户输入中收集的数据进行特定调用,并将该数据保留在中华人民共和国境内。值得注意的是,使用开放模型的应用程序的安全性需要其自身全面的安全分析和法律考虑:

结论

开源 AI 的功能不断加速,企业需要通过适当的安全控制来实现业务目标。没有 AI 的安全性,就不应该有企业采用 AI。

原文始发于微信公众号(梅苑安全):DeepSeek训练过程解读以及AI安全性分析

- 左青龙

- 微信扫一扫

-

- 右白虎

- 微信扫一扫

-

评论