原因

ChatGPT、Claude、Grok3、DeepSeek等在线AI工具虽然好用且免费,但是有无法避免的问题:

-

个人数据隐私无法保证,一不小心问的问题就会带上个人数据; -

敏感问题不响应,如询问一些漏洞利用技巧; -

网络故障,经常“请稍后再试”。 这样低成本搭建一个本地AI就是刚需。

方法

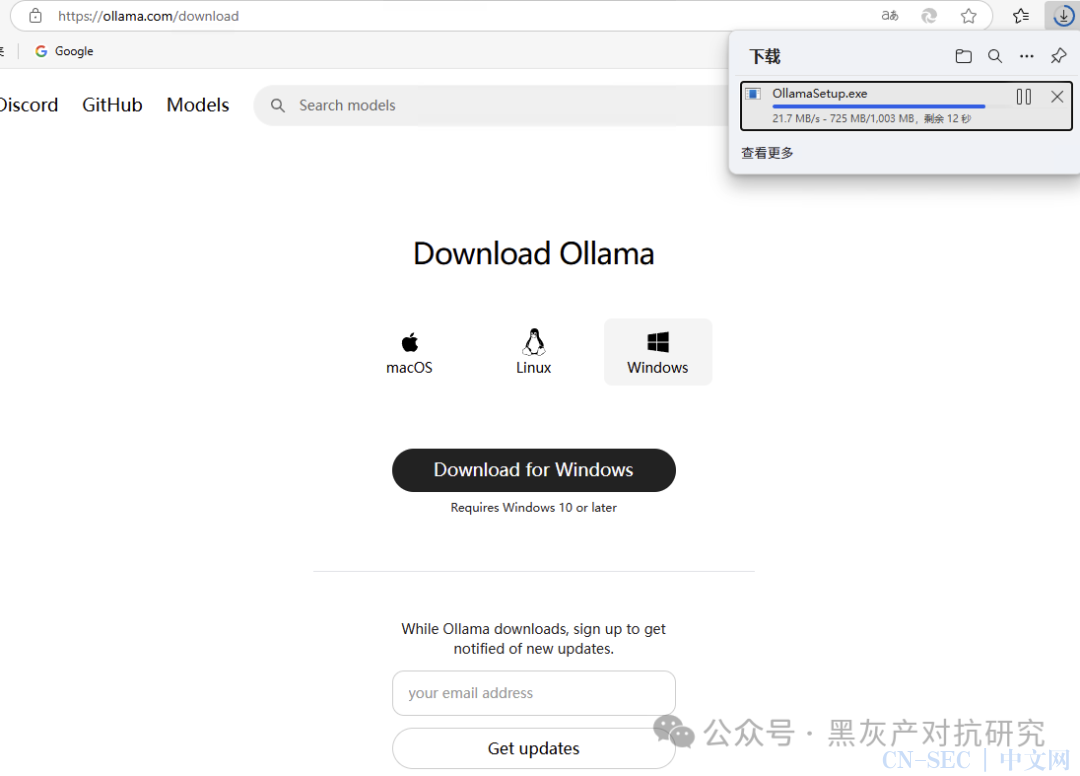

在https://ollama.com/根据自己平台下载ollama,然后在https://ollama.com/search选择自己需要的模型。

这里我选择了DeepSeek-r1,70B模型,因为我的电脑内存是64G对于70B来说够用。如果你的内存小(是内存条,不是硬盘),请选择7B或更小。终端直接run即可。终端直接对话,基本1~2token/s

优化

图形界面选择cherryStudio搭建个人本地知识库,设置里选择ollama即可自动识别本地的AI,在【管理】里面添加一下,回到消息页面在标题栏改成此模型就能对话。

进阶

知识库

如果你有几百G甚至几百T的本地文件需要查阅,使用知识库就可以完成类似sql查询的效果。方法也很简单,设置里开启模型的嵌入式推理功能,再在聊天页面选择此知识库即可正常对话询问。

MCP 可以理解为多个agent帮你自动联网搜索、使用各个软件操作,形成一个高度可行性的工作流。比如自动联网帮你解决问题:

其他

尝试过多个工具,对于普通用户来说cherry studio是对于那些想在ai领域更进一步的最为简单高效的软件,值得一试。

我的PC是16核32线程64G内存,现在部署32b能达到3-5token/s。如果有一张3060以上的显卡能达到10以上,其实够用。最主要的是达到了数据可控。

性价比显卡推荐:2080Ti 22G、3080、3090 24G、4090

引用

https://docs.cherry-ai.com/advanced-basic/mcp

原文始发于微信公众号(黑灰产对抗研究):低成本本地部署DeepSeek

- 左青龙

- 微信扫一扫

-

- 右白虎

- 微信扫一扫

-

评论